Sistemas de Inteligência Artificial(IA) tiveram um boom midiático nos últimos meses, com ChatGPT, Bard e tantos outros, frequentando o nosso dia a dia em forma de notícias, treinamentos, seminários e etc. Apesar dessa “novidade”, acredite se quiser, os estudos de IA iniciaram na segunda metade dos anos 50. Passaram por um período de descrença nos anos 70 e 80 mas recuperou o fôlego nos nos anos 90, com o advento da internet. Nos anos 2000-2010, com a popularização das GPUs (sim, placas de vídeo), os estudos voltados a IA se firmaram como tendência viável.

Você pode também não acreditar, mas com absoluta certeza você já teve a vida facilitada por inteligência artificial muito antes do aparecimento do ChatGPT. Sistemas de antivírus, reservas de voos, auxiliares de voz, marketing direcionado, ferramentas de anti-spam e tantas outras já se valem da inteligência artificial há alguns anos. Certamente que o que estamos presenciando hoje é um acesso muito mais democrático a estes sistemas fascinantes que “sabem tudo”.

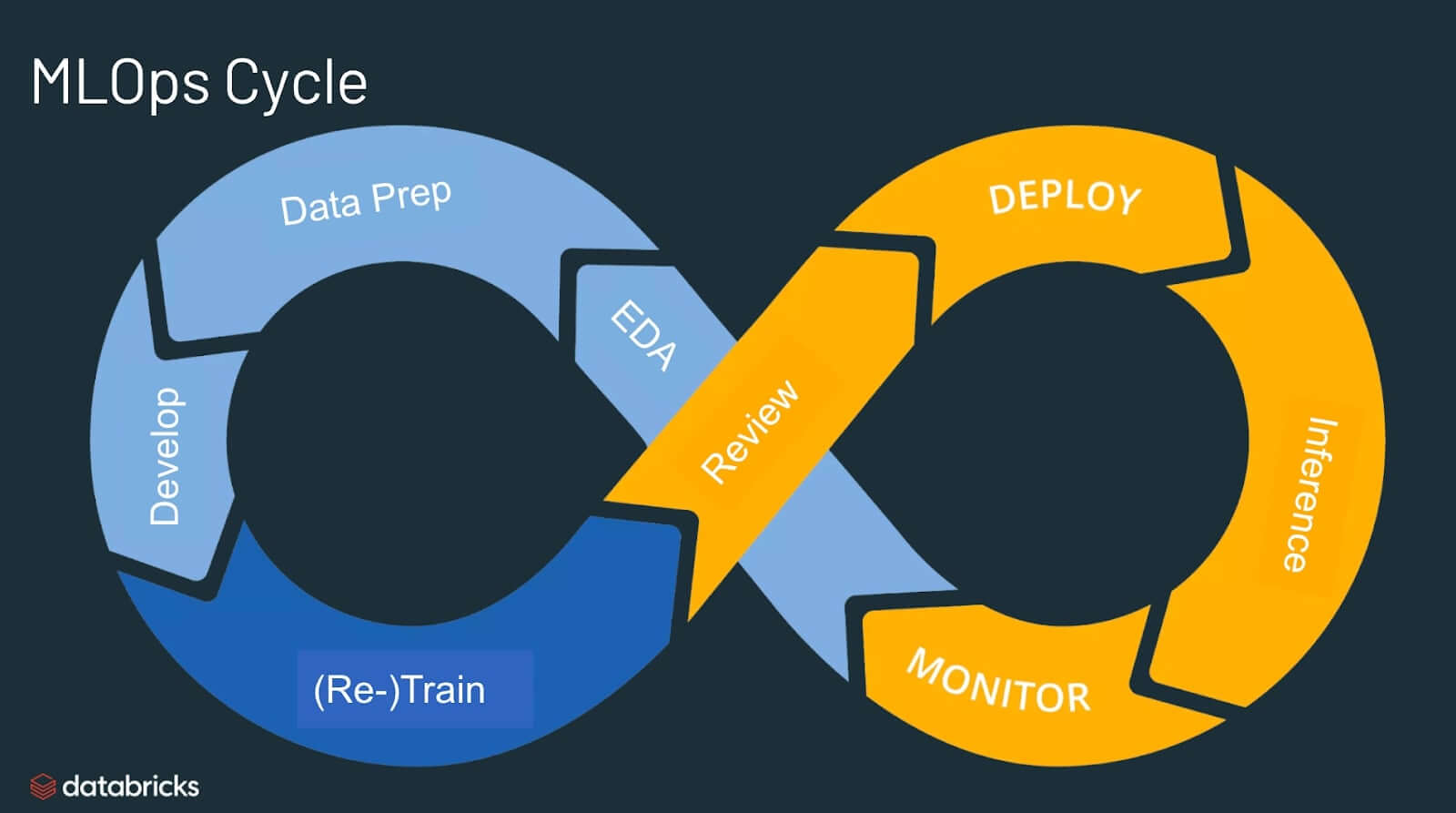

Sendo bastante simplista na definição (e correndo o risco de causar a ira de alguns entusiastas), sistemas de IA são sistemas informáticos, como qualquer outro. Passam por seus ciclos de desenvolvimento, projeto, modelagem, testes, implantação e etc. Dessa forma, que é comum a qualquer sistema, um sistema de IA também pode ter suas vulnerabilidades.

À medida que os sistemas modernos de IA são cada vez mais populares e começam a ser utilizados em infraestruturas críticas, saúde e outras áreas sensíveis, é importante compreender as potenciais vulnerabilidades desses sistemas a ataques.

Tipos de Ataques à IA

Existem várias maneiras de os sistemas de IA serem atacados. Alguns dos tipos mais comuns de ataques à IA incluem:

Envenenamento de Dados (Data Poisoning): Este tipo de ataque envolve a injeção de dados maliciosos nos dados de treinamento utilizados para treinar um sistema de IA. Isso pode fazer com que o sistema de IA aprenda padrões incorretos, o que pode levar a erros em suas previsões ou decisões.

Inversão de Modelo (Model Inversion): Este tipo de ataque envolve a engenharia reversa de um modelo de IA para extrair informações sensíveis dele. Por exemplo, um invasor poderia usar a inversão de modelo para extrair os dados de treinamento utilizados para treinar um sistema de IA, ou para aprender os parâmetros do modelo em si.

Evasão (Evasion): Este tipo de ataque envolve a criação de entradas que farão com que um sistema de IA faça previsões ou decisões incorretas. Por exemplo, um invasor poderia criar uma imagem que parece um gato para um sistema de IA treinado para reconhecer gatos, mas que na verdade contém uma mensagem oculta.

Aprendizagem de máquina adversarial (Adversarial Machine Learning): Este tipo de ataque envolve o uso de técnicas de aprendizado de máquina para criar ataques especificamente adaptados a um sistema de IA em particular. Os ataques de aprendizado de máquina adversarial podem ser muito difíceis de defender, pois podem explorar as fraquezas específicas de um sistema de IA.

Implicações de Segurança Cibernética dos Ataques à IA

As implicações de segurança dos ataques à IA são significativas. Sistemas de IA estão sendo cada vez mais utilizados em infraestruturas críticas, como redes elétricas e sistemas de transporte. Se esses sistemas forem atacados, as consequências poderiam ser catastróficas.

Além disso, os sistemas de IA estão sendo usados em saúde, serviços financeiros e outras indústrias sensíveis. Se esses sistemas forem atacados, as consequências poderiam ser perdas financeiras, roubo de identidade ou até mesmo perda de vida.

Estratégias de Mitigação

Existem várias estratégias de mitigação que podem ser usadas para reduzir o risco de ataques à IA. A grande maioria delas é bastante similar a estratégias recomendadas para sistemas em geral e recomenda-se que sejam parte ativa do ciclo de MLOps.

Estas incluem:

Segurança de dados: É importante garantir a segurança dos dados de treinamento utilizados para treinar os sistemas de IA. Isso inclui o uso de criptografia e controle de acesso para prevenir o acesso não autorizado aos dados.

Segurança do modelo: É importante garantir a segurança dos próprios modelos de IA. Isso inclui o uso de criptografia e controle de acesso para prevenir o acesso não autorizado aos modelos e o uso de técnicas como a ofuscação de modelos para tornar mais difícil a engenharia reversa dos modelos.

Detecção de ataques: É importante ter sistemas para detectar ataques à IA. Isso inclui o uso de técnicas de detecção de anomalias para identificar atividades suspeitas e o uso de técnicas de aprendizado de máquina para identificar padrões de ataques conhecidos.

Conclusão

A segurança dos sistemas de IA é uma preocupação de extrema importância que requer atenção imediata. À medida que a adoção da inteligência artificial se expande, o risco de ataques também aumenta significativamente. É crucial implementar estratégias de mitigação eficazes para reduzir esse risco e desenvolver novas técnicas de defesa contra esses ataques. E para lhe ajudar neste processo muito importante, conte com os especialistas da EximiaCo. Entre em contato conosco e saiba como nossos serviços de Adoção de Processos Seguros pode contribuir nesta jornada.

Para finalizar, gostaria de expressar um agradecimento especial ao nosso especialista em Inteligência Artificial, Thiago Candido. Trabalhando em conjunto, tivemos várias discussões sobre esse tema que resultaram em valiosos insights. Sua experiência e conhecimento contribuíram significativamente para o enriquecimento de nossas reflexões nessa área.